从概念上看看深度学习为什么成功?

这里以概念分析为主叙述深度学习的部分理论基础。主要摘录了CVPR 2016 Tutorial里The mathematics of deep learning 的Data structure based theory for deep learning 报告要点。[1]

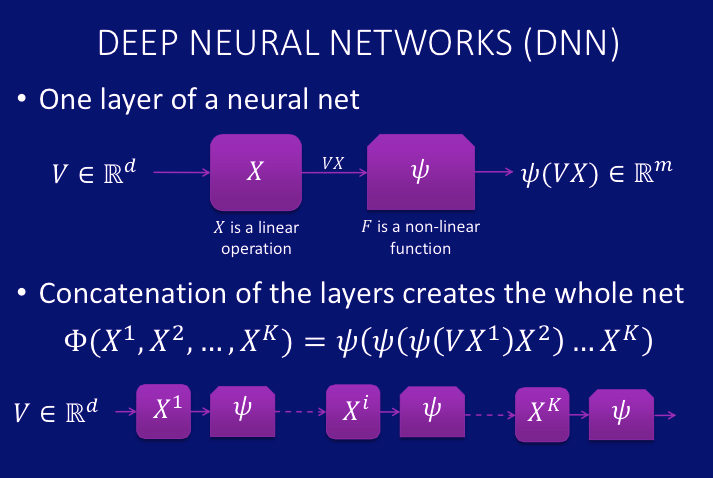

深度学习的核心结构是深度神经网络。

深度神经网络是一系列线性和非线性变化的网络层堆叠。

深度神经网络的若干重要理论性质包括:

1,可表示任意函数(Universal approximation for any measurable Borel functions);

2,随着深度增加,神经网络的表达能力呈指数增长;

3,随着深度增加,神经网络有更多的局部最优点接近全局最优点。

从具体的网络层的结构设计和数值初始化来说:

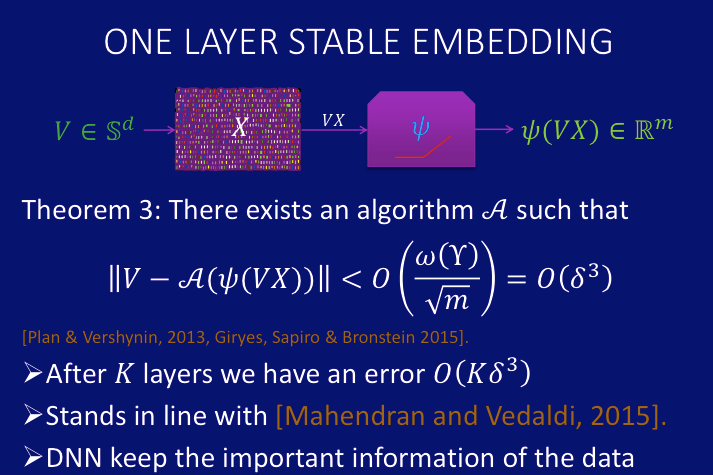

1,深度神经网络可以保留输入数据的重要信息;

即通过一层网络变换后的信息和输入信息的差异有上限理论保证。

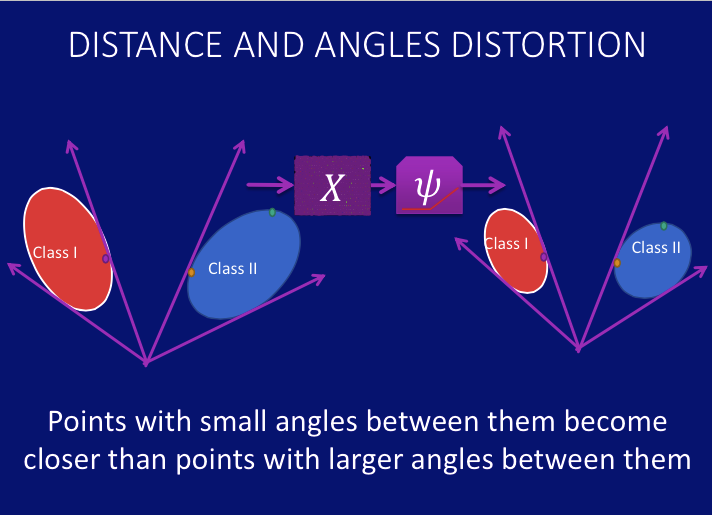

2,使用随机高斯分布初始化权值,神经网络能保持样本间的距离和角度序关系;

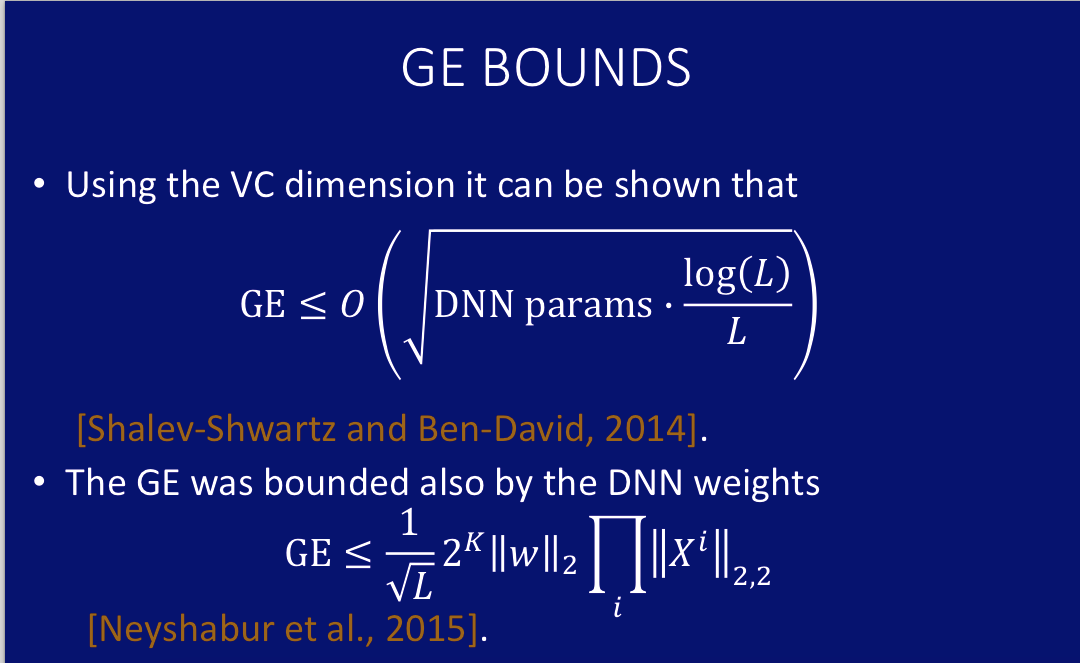

3,深度神经网络的泛化能力具有理论保证;

即深度神经网络在训练集和测试集的精度误差存在理论上线。

以上述若干性质为基础,设计神经网络结构和目标函数以引导信息的变换和流动,辅以合适的初始化和训练方法,深度学习在很多任务上获得了突破性进展。尤其是非结构化数据的处理,语音,文本,图像等等。

[1] http://www.vision.jhu.edu/tutorials/CVPR16-Tutorial-Math-Deep-Learning-Raja.pdf